Stable Diffusion tout ce qu’il faut savoir : Guide complet

Publié par Thomas Leroy le dans Stable Diffusion

Temps de lecture estimé : 5 min

Ces dernières années, le monde de l’IA générative a connu un succès sans précédent. Midjourney, Dall-E, etc. sont parmi les outils de génération d’images qui font le plus parler d’eux. Mais cette grande famille de technologies comprend également Stable Diffusion. Ce nom vous dit quelque chose ? Il s’agit en effet de l’une des IA de conversion de texte en image les plus puissantes. Mais par rapport à ses concurrents, tels que Midjourney, Stable Diffusion est assez complexe à utiliser. Mais il offre des options de traitement et de génération d’images plus approfondies. Qu’en est-il de cet outil ? Comment fonctionne-t-il ? C’est ce que je vais vous expliquer dans cet article, alors prenez place !

Qu’est-ce que Stable Diffusion ?

Comme l’IA génératrice d’images, Stable Diffusion est un modèle d’apprentissage automatique “text-to-image”. Cet outil intelligent a été créé par une entreprise londonienne spécialisée dans l’intelligence artificielle. Runway et plusieurs chercheurs de l’université de Munich ont conçu la première version de Stable Diffusion en 2021. La start-up Stability.AI a financé les coûts de calcul liés à l’apprentissage du modèle. Suite à cette collaboration, Stable Diffusion a vu le jour le 22 août 2022.

Il est à noter que Stable Diffusion est partagé en open source et accessible gratuitement, ce qui lui confère un avantage par rapport à la concurrence qui impose plutôt un abonnement. Dall-E est l’un des concurrents directs de Stable Diffusion. En fait, les deux outils sont basés sur presque le même processus, connu sous le nom de diffusion de latence. Il s’agit d’un réseau neuronal génératif profond. Pour lancer la commande, la génération d’images nécessite un script « texte-image » demandant des descriptions textuelles, communément appelé « prompt ». Le processus de diffusion de la latence permet à l’outil d’offrir une large gamme de styles et une résolution d’image plus élevée.

Comment fonctionne Stable Diffusion ?

Avant d’entrer dans les détails, il faut savoir qu’en utilisant un réseau neuronal génératif profond, Stable Diffusion est basée sur un modèle mathématique de diffusion. Ainsi, son processus de génération d’images est basé sur l’encodage d’un texte dans un vecteur latent. Si vous n’êtes pas familier avec ce terme, le vecteur latent fait allusion à la représentation acquise par le réseau neuronal au fur et à mesure de son apprentissage, qui est ensuite utilisée pour générer de nouvelles données, à savoir des images. Une fois l’invite formulée et validée, le modèle est progressivement diffusé, transformant le vecteur latent en image. Cette diffusion fait évoluer l’image à partir d’un bruit blanc, la transformant progressivement en une image réaliste. Enfin, pour prendre le contrôle du processus de génération, notamment pour le modifier, il suffit de modifier le vecteur latent.

Bien que les termes soient assez techniques, il suffit de se rappeler les concepts clés suivants :

- Le vecteur latent, qui s’appuie sur l’encodeur VAE pour compresser l’image en la déplaçant de l’espace pixel à l’espace latent afin de la condenser et de mieux la structurer.

- Le modèle de diffusion, qui utilise le bruit blanc pour appliquer la représentation latente compressée de manière interactive pendant la diffusion.

- Le post-traitement, basé sur le bloc DU-Net et constitué d’un cadre ResNet. Il permet de débruiter la sortie de la diffusion avant d’obtenir la représentation latente.

- La sortie post-diffusion, avec le décodeur VAT qui génère l’image finale. Il convertit la représentation de l’espace latent à l’espace pixel.

Quelles sont les versions disponibles de l’outil ?

Depuis son lancement en 2022, la Stable Diffusion a été déclinée en plusieurs versions. Vous trouverez

- Stable Diffusion 1.0

- Stable Diffusion 1.5

- Stable Diffusion 2.1

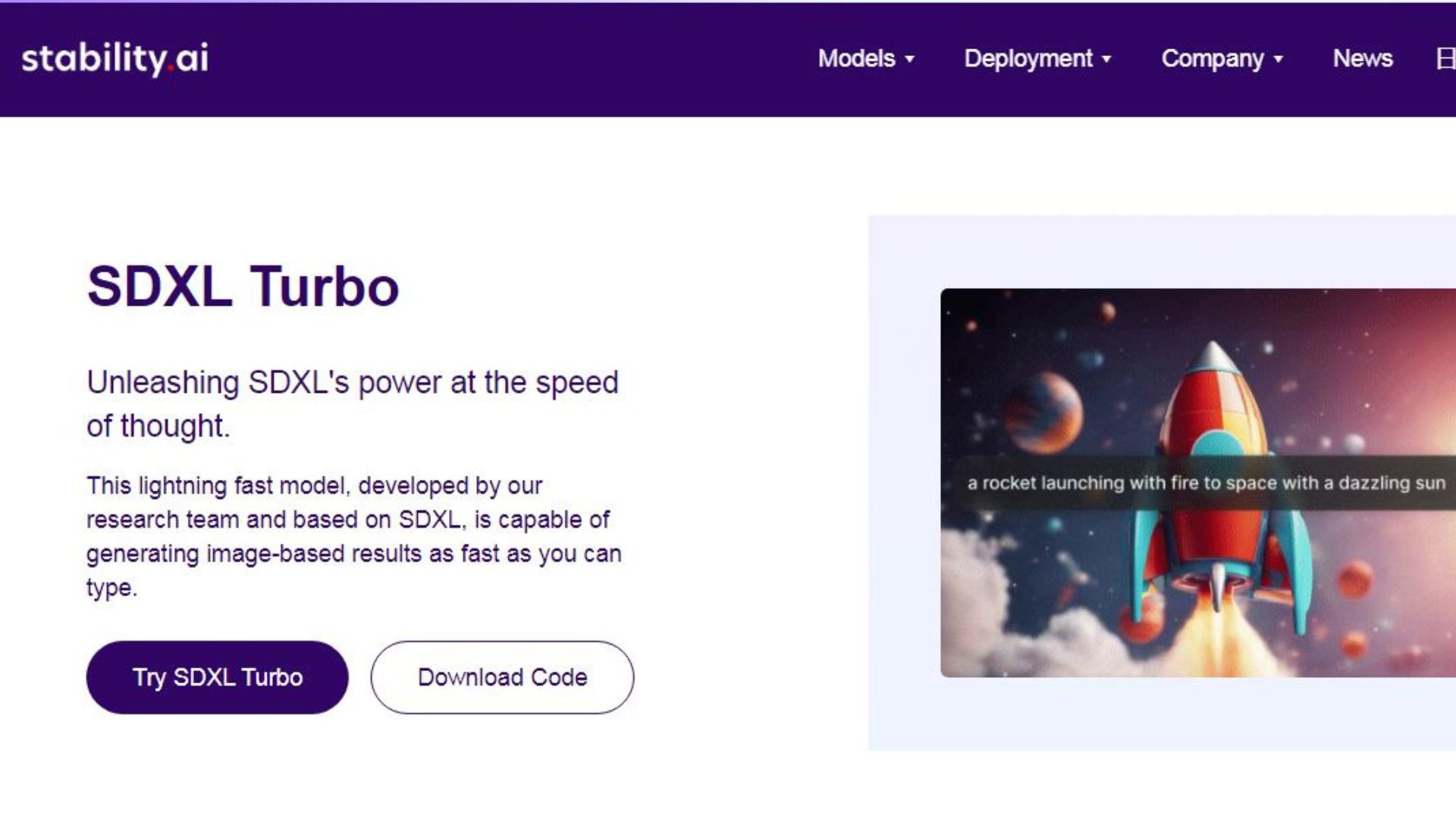

- Stable Diffusion XL et XL turbo

- Stable Diffusion 3.0

La première version de Stable Diffusion 1.0 n’a pas été assez connue, car elle n’était alors qu’un prototype. C’est avec la version 1.5, sortie en 2022, que l’IA générative a commencé son voyage. Partagé en open-source, ce modèle était conçu pour des images de 512×512 pixel. Stable Diffusion 1.5 est un succès, avec sa vitesse impressionnante et sa faible utilisation de la mémoire. Cette version voit également l’apparition de nombreux nouveaux modèles créés par la communauté des utilisateurs. Il s’agit de modèles affinés basés sur SD1.5.

Stable Diffusion 2.1 est sorti en décembre 2022. Elle n’a pas connu le même succès que SD1.5. Malgré le fait qu’elle puisse optimiser les images 768×768 pixel, les critiques sur son utilisation complexe et les faibles améliorations par rapport à la version précédente en ont fait la version la moins appréciée.

C’est à partir de Stable Diffusion XL que les performances ont grimpé d’un cran. Depuis cette version, l’outil est capable d’optimiser des images de 1024×1024 pixels avec un rendu réaliste. Sa popularité a dépassé celle de ses prédécesseurs. Mais cette année, Stability.Ai a annoncé l’arrivée de Stable Diffusion 3.0, qui promet d’être encore plus puissant, avec la possibilité d’optimiser de 800 millions à 8 milliards de paramètres. Malheureusement, cette version n’est pas encore ouverte au public, car elle nécessite encore des améliorations.

Ces différentes versions de Stable Diffusion (à l’exception de la version 3.0) peuvent être exécutées sur votre propre ordinateur sans accès à Internet. Pour ce faire, vous avez besoin d’Automatic1111 ou de ComfyUI, des interfaces utilisateur graphique nécessaire pour exécuter l’outil localement. Stable Diffusion fonctionne sous Windows (10 et 11) et Mac (puces M1 ou M2), mais nécessite une machine puissante avec un GPU de 8 Go.

Stable Diffusion est un outil de génération d’images assisté par l’IA, classé dans la catégorie des modèles « text-to-image ». Bien que la concurrence soit féroce, ce logiciel tient la corde grâce à sa propre innovation utilisant un réseau neuronal génératif profond. L’IA est ainsi capable d’analyser et de traiter l’image en profondeur. Actuellement disponible en 5 versions principales, Stable Diffusion présentera la version 3.0 avec des options plus avancées et plus pratiques. Mais répondra-t-elle aux attentes des utilisateurs ou se distinguera-t-elle peu de Stable Diffusion XL ?